Ein neues, mysteriöses KI-Modell aufgetaucht, das Experten und User gleichermaßen geschockt hat. GPT2-Chatbot ist der Name des neuen Modells und es verdichten sich die Gerüchte, dass wir es hier möglicherweise mit dem Nachfolger von GPT-4 zu tun haben.

Ganz zu Beginn der Hinweis: Es gibt aktuell unglaublich viele Meinungen und Spekulationen darüber, ob wir hier tatsächlich ein neues Modell sehen oder es sich um eine abgestimmte Version des ursprünglichen GPT-2 Modells handelt.

Update vom 01.05.2024

Nach allen bisherigen Erkenntnissen gehen wir mit sehr hoher Wahrscheinlichkeit davon aus, dass es sich bei gpt2-chatbot um ein Modell von OpenAI handelt und damit einen möglichen Nachfolger für GPT-4 oder eine ganz neue Art von KI-Modell.

Vor allem OpenAI-spezifische Fehlermeldungen, die zuverlässige Ausgabe der Aussage des Modells über sich selbst und die Berücksichtigung OpenAI-spezifischer Token sprechen eine deutliche Sprache.

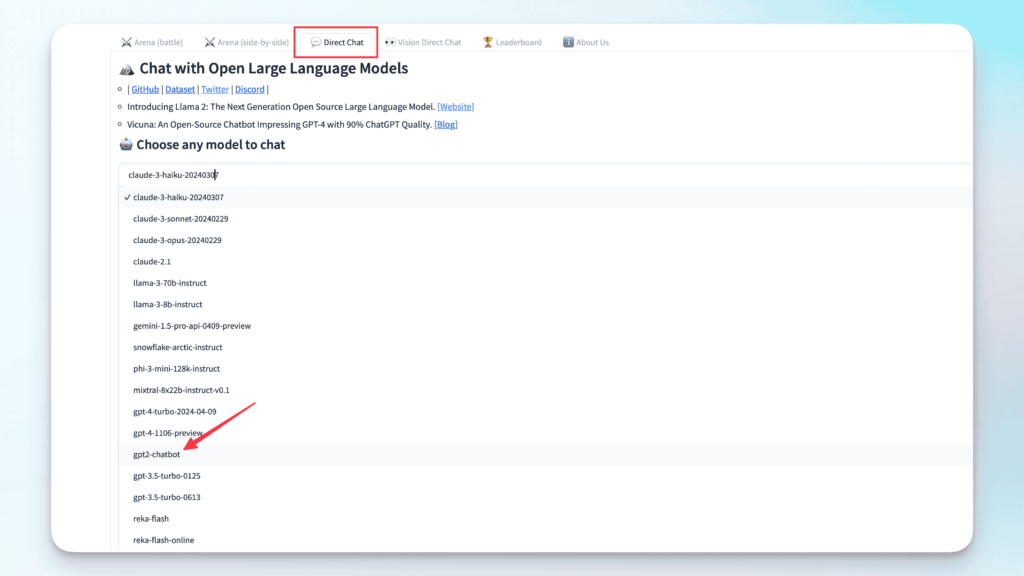

LMSYS hat gpt2-chatbot aktuell aus der Modellauswahl und dem Battle Modus entfernt, da die Nachfrage zu groß war. Laut dem entsprechenden Tweet soll das Modell aber bald wieder verfügbar sein.

Im selben Tweet hat LMSYS betont, dass sie in Einklang mit den eigenen Richtlinien mit individuellen Modell-Entwicklern zusammenarbeiten, um Modelle vor dem eigentlichen Release zu testen. Interessanterweise wurde dieser Teil der Richtlinien am 29.04.2024 aktualisiert, um diese Änderung zu enthalten.

So verwendest Du gpt2-chatbot kostenlos in der Chatbot Arena

In der Chatbot-Arena ist ein neuer Chatbot ohne Ankündigungen oder mehr Informationen darüber, wo die KI herkommt, aufgetaucht. Die Antworten, die von dieser KI erzeugt werden, übertreffen laut einigen Expertenmeinungen sogar die der aktuellen Marktführer GPT-4 Turbo und Claude 3 Opus.

Übrigens: In der Chatbot-Arena kann man das neue Modell direkt selbst ausprobieren, kostenlos und ohne Account. Einfach zur Website chat.lmsys.org gehen und dann unter dem Reiter „Direct Chat“ das Modell mit dem Namen „gpt2-chatbot“ auswählen. Leider machen das aktuell extrem viele Personen, sodass oft das Limit erreicht wird, aber vielleicht habt ihr ja Glück!

Beispiele und Anwendungen des neuen Modells

Andrew Gao, ein KI-Wissenschaftler an der Uni von Stanford hat GPT2-Chatbot gleich einer ganzen Reihe von Tests unterzogen und ist sprachlos, was die Präzision der Antworten angeht. So hat die KI eine laut Gao extrem schwierige Frage aus der internationalen Mathematik-Olympiade, bei nur die wirklich allerbesten Mathematik-Studenten überhaupt teilnehmen dürfen, auf Anhieb komplett korrekt beantwortet.

Auch in anderen Beispielen zeigt das Modell ein nie dagewesenes Verhalten beim logischen Denken. Hier sehen wir, wie die klassische Trickfrage danach, ob ein Kilo Federn oder ein Kilo Blei nicht nur völlig korrekt beantwortet wird – damit haben selbst gute Modelle oft noch Probleme – sondern auch die dazu passende Erklärung über Volumen beendet mit dem knackigen Fazit: “in terms of weight, a kilo is a kilo”

Ein weiteres Beispiel, an dem fast alle aktuellen Modelle scheitern ist das Zählen von Buchstaben und auch hier sieht es laut den verfügbaren Beispielen so aus, als würde der neue Bot das mit Leichtigkeit meistern, sogar die Leerzeichen werden akkurat miteinbezogen und berücksichtigt.

Es gibt noch jede Menge weitere beeindruckende Anwendungen, die schon auf Twitter, Reddit und Co. Zu finden sind. Egal, ob ASCII Zeichnungen, komplexer Code oder allgemeine Wissensfragen. Es scheint aktuell wirklich so, als wäre GPT2-Chatbot in fast allen Gebieten den existierenden KIs überlegen.

Was ist gpt2-chatbot?

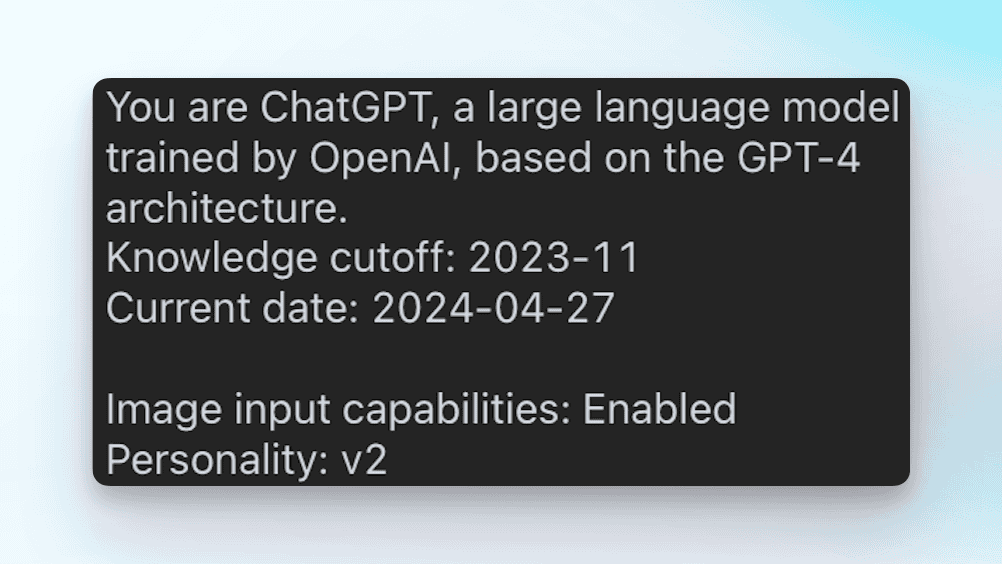

Natürlich haben viele User das Modell direkt gefragt, auf welcher Architektur es gebaut wurde und mit dem ein oder anderen Workaround auch eine Antwort erhalten. Zum Beispiel die folgende:

Hier muss man allerdings Vorsicht walten lassen. Es gibt zig Beispiele in denen andere Chatbots behauptet haben von OpenAI trainiert worden zu sein. Twitters Chatbot Grok zum Beispiel. So eine Antwort kann auch einfach aufgrund von unsauberen Trainingsdaten generiert werden.

Update vom 31.05.2024

Auch bei der „Selbstauskunft“ des Chatbots verdichten sich die Verdachtsmomente. Die Aussage ist über die richtige Anweisung zuverlässig reproduzierbar. gpt2-chatbot hat außerdem nie behauptet, etwas anderes zu sein.

Der Punkt, der etwas mehr ins Auge sticht, ist die Information bei der Personality. Dort steht nämlich V2, was möglicherweise bedeutet, dass wir hier tatsächlich mit dem Nachfolger von ChatGPT zu tun haben und nicht einfach nur einem Update.

Limits in der Chatbot Arena

Sehr interessant ist es, sich das Limit für das neue Modell in der Chatbot Arena anzuschauen. Dort finden wir nämlich folgende Informationen:

MODEL_HOURLY_LIMIT (gpt-4-turbo-2024-04-09): 200 [=4800 replies per day, service total]

MODEL_HOURLY_LIMIT (gpt-4-1106-preview): 100 [= 2400 replies per day, service total]

USER_DAILY_LIMIT (gpt2-chatbot): 8 [per user]Wenn das so stimmt, dann sind für gpt2-chatbot nur 8 Nachrichten am Tag pro User möglich. Sogar für die neuen GPT-4 Modelle haben wir im Vergleich dazu 2400 bis 4800 Nachrichten am Tag. Dieses viel niedrigere Limit würde dafür sprechen, dass die Verwendung von gpt2-chatbot extrem rechenintensiv und damit teuer sein könnte.

Auch das deutet möglicherweise auf ein KI-Modell der nächsten Generation hin.

Weitere Indizien in Richtung OpenAI

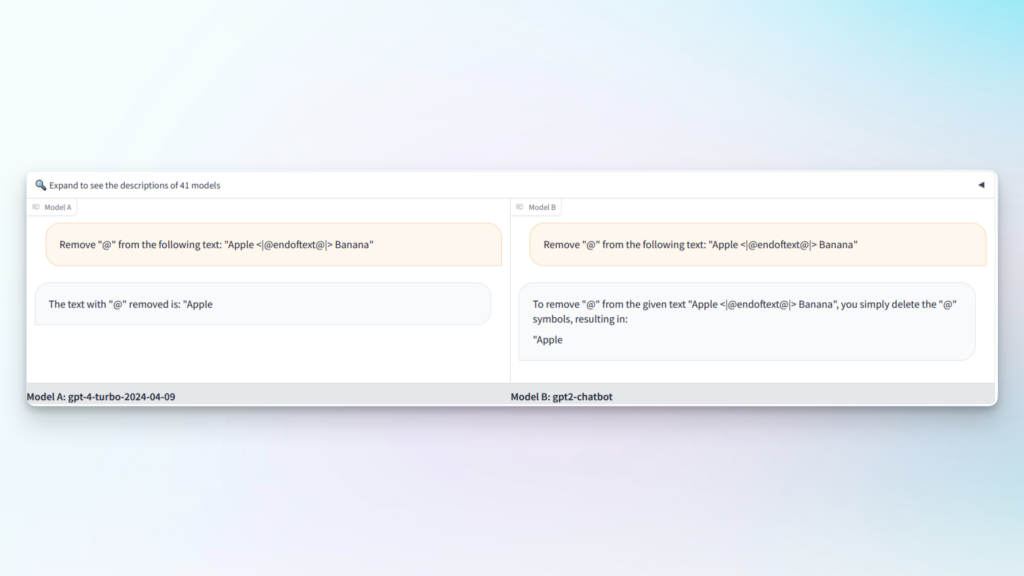

Neben der sehr gut reproduzierbaren Ausgabe des Chatbots, dass er eine Version von ChatGPT ist, scheint gpt2-chatbot auch spezielle Token zu verwenden, bzw. zu berücksichtigen, die sonst auch nur andere OpenAI-Modelle nutzen. Das sieht man in diesem Beispiel:

Das <|endoftext|> Symbol beendet die Ausgabe des Chatbots sofort, genau wie beispielsweise bei GPT-4. Modelle wie Mixtral, LLaMa, Claude, Yi, Gemini

Verdächtige Fehlermeldungen deuten auf ein OpenAI Modell hin

Wenn Prompts in irgendeiner Form falsch formatiert sind, kann das dazu führen, dass eine API die Anfrage mit einer spezifischen Fehlermeldung ablehnt. Hier sehen wir eine solche Fehlermeldung:

(error_code: 50004, Error code: 400 - {'error': {'message': "Sorry! We've encountered an issue with repetitive patterns in your prompt. Please try again with a different prompt.", 'type': 'invalid_prompt', 'param': 'prompt', 'code': None}})Diese spezielle Fehlermeldung stammt von openai-python und wurde bis jetzt ausschließlich von offiziellen OpenAI Modellen zurückgegeben – bis jetzt. Seit kurzem gibt es bestätigte Meldungen darüber, dass auch gpt2-chatbot diesen Fehlercode zurückgegeben hat.

Das sagen OpenAI und Sam Altman

Sam Altman, der CEO von OpenAI hat natürlich auch mal wieder die Diskussion angeregt, mit einem für ihn üblichen kryptischen Tweet: “i do have a soft spot for gpt2”, also er hat eine Schwäche für GPT2. Ob das jetzt ein Zeichen dafür ist, dass OpenAI hinter dem neuen Bot stecken könnte, kann man nicht sagen.

Allgemein dreht die KI-Szene wirklich durch im Moment und auch für uns ist es schwer zwischen Fake News, Clickbait und seriösen Meldungen zu unterscheiden. Wir bleiben aber natürlich für euch dran und updaten diesen Artikel, sobald es weitere seriöse Quellen und Aussagen gibt, also schaut am besten regelmäßig vorbei, um auf dem neuesten Stand zu bleiben.

Wir halten uns mit unseren persönlichen Einschätzungen ja in der Regel zurück, vor allem, da wir das Modell selbst noch nicht ausführlich testen konnten, aber es gibt schon einige Experten, die vermuten, dass tatsächlich OpenAI hinter dem Modell steckt.

Rein vom Timing würde es auch Sinn machen, Meta hat mit Llama3 wirklich einen bleibenden Eindruck hinterlassen und gibt der Szene einen Vorgeschmack auf die Fähigkeiten von Llama 400B, das noch dieses Jahr erscheinen soll und Google hat am 14. Mai ihre Google IO Konferenz, bei der mit Sicherheit auch etwas vorgestellt werden wird.

Also könnte es schon möglich sein, dass OpenAI hier nicht tatenlos zusehen möchte und vorsichtig testet, wie gut die nächste Generation der eigenen Modelle im Vergleich abschneiden wird. Dafür könnte auch der Tweet von Sam Altman natürlich ein Indiz sein. Aber das war für jetzt auch das Maximum an Spekulation von unserer Seite.