Früher als erwartet hat OpenAI eine Vorschau der neuen Generation von KI-Modellen vorgestellt – O1 und O1-mini. In diesem Artikel wollen wir euch in wenigen Minuten einen Überblick geben, was die neuen Modelle können und wie sich sich von allem, was wir bisher kennen unterscheiden.

Wir sind schon dabei selbst genau zu testen und eigene Erfahrungen zu sammeln – die bekommt ihr dann nächste Woche in einem ausführlichen Video auf YouTube vorgestellt.

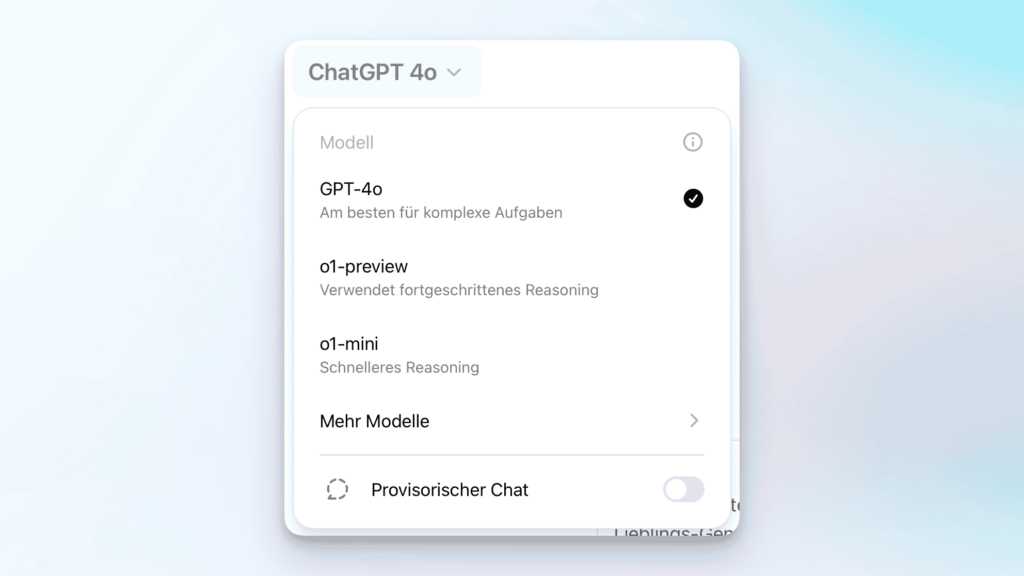

Die neuen OpenAI-Modelle O1-preview und O1-mini-preview

Zunächst einmal die Eckdaten: Wie schon erwartet handelt es sich bei den jetzt in ChatGPT für alls User ab einem Plus-Plan verfügbaren neuen Modelle nicht um die finalen Versionen der neuen Generation. Das sieht man auch leicht an dem Namen, der das Wort preview, also Vorschau enthält.

OpenAI hat sich dazu entschieden mit diesem aktuellen Stand jetzt Erfahrungswerte zu sammeln, nachdem sie geklärt haben, dass die Verwendung dieser neuen Modelle kein höheres Sicherheitsrisiko darstellt, als es die aktuellen Modelle tun – so ist zumindest die Formulierung des Safety-Teams.

Was können die neuen OpenAI-Modelle?

Die Modelle erreichen einen völlig neuen Standard bei komplexen Aufgaben, wie Mathematik, Coding und wissenschaftlichem Arbeiten.

Hier sind einige Demo-Videos von OpenAI, die die neuen Fähigkeiten der Modelle in Aktion zeigen:

O1 entwickelt ein Snake-Spiel

Mit dem Laden des Videos akzeptieren Sie die Datenschutzerklärung von Vimeo.

Mehr erfahren

O1 hilft bei der Quantenphysik

Mit dem Laden des Videos akzeptieren Sie die Datenschutzerklärung von Vimeo.

Mehr erfahren

O1 löst eine (für KI-Modelle) schwierige Frage

OpenAI o1 answers a famously tricky question for large language models. pic.twitter.com/5ZlQIOBWEd

— OpenAI (@OpenAI) September 12, 2024

O1 löst ein Logik-Rätsel

OpenAI o1 solves a complex logic puzzle. pic.twitter.com/rpJbh8FkAg

— OpenAI (@OpenAI) September 12, 2024

Wir werden euch jetzt hier nicht mit den ganzen Benchmark-Zahlen langweilen, haben aber natürlich für euch den ganzen technischen Report von OpenAI, dort findet ihr alle Tabellen, Grafiken, etc. Wenn euch das interessiert. Wir sprechen aber kurz darüber, wie die Modelle diese Leistung erbringen: Im Prinzip ist es eine eingebaute Reflektion, der sogenannten Chain-of-Thought, der vor dem eigentlichen Output steht.

Das funktioniert eigentlich genau wie bei uns Menschen, wenn wir schwierige Fragen oder Probleme lösen müssen. Dabei denkt man am besten in Einzel-Schritten nach.

Für jeden Schritt versucht das Modell, seine Fehler zu finden und zu verbessern. Es teilt schwere Aufgaben in kleinere, leichtere Teile auf. Und wenn etwas nicht klappt, probiert es etwas Neues aus. OpenAI hat dazu selbst einige Beispiele für Coding, Mathe und Verschlüsselungsfragen auf der Website, in denen man auf beeindruckende Art und Weise sieht, wie lange dieser Prozess teilweise geht. Das Modell spielt zig verschiedene Szenarien sozusagen “hinter den Kulissen” durch, bis die finale Antwort gegeben wird.

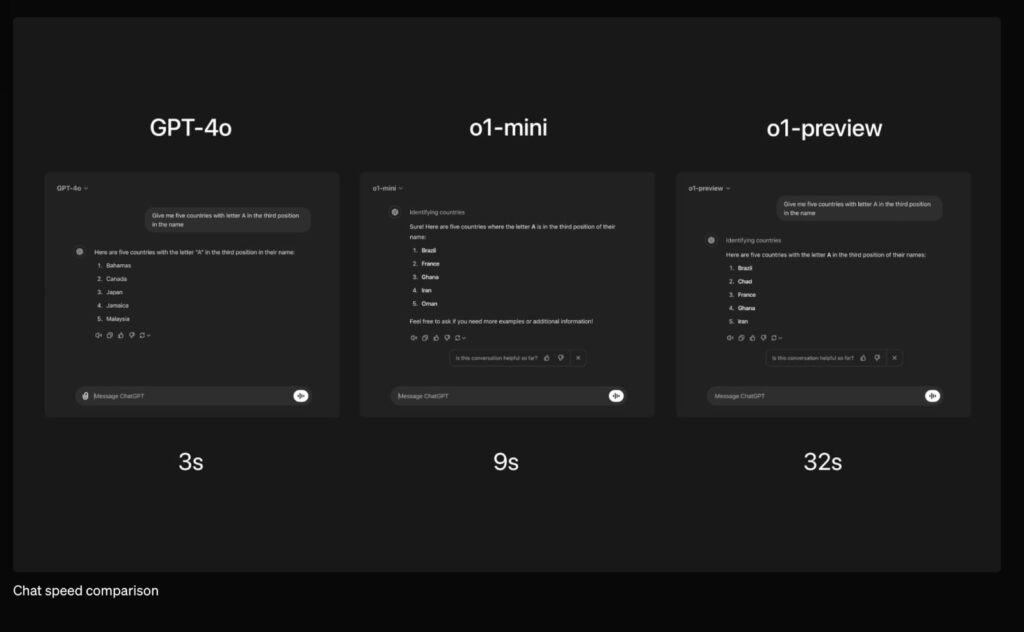

Alle aktuellen KI-Modelle geben in der Regel eine schnelle Antwort, die bei so komplexen Fragen dann eben oft auch falsch ist. Hier versucht O1 anders zu arbeiten und alles erst einmal zu hinterfragen und zu prüfen, bevor die finale Ausgabe generiert wird.

Was ist der Unterschied zwischen o1-preview und o1-mini?

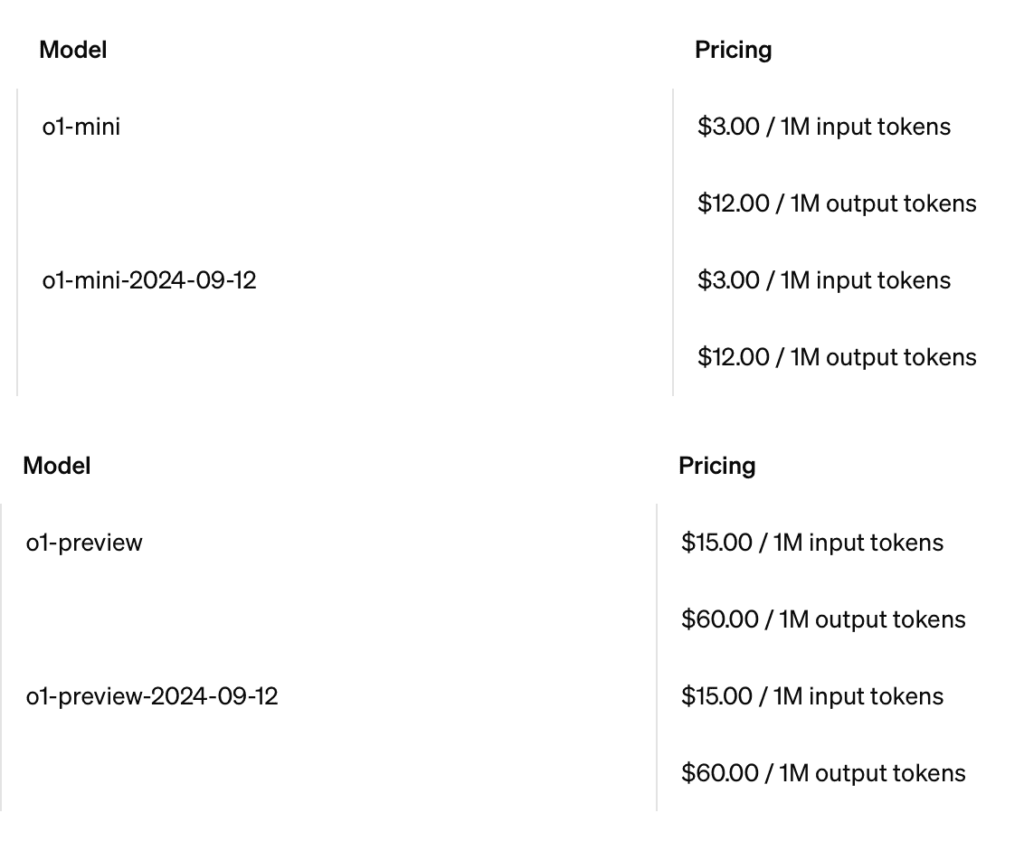

Der hauptsächliche Unterschied zwischen dem o1-preview und dem o1-mini Modell liegt in der Kosteneffizienz und Geschwindigkeit. Die Nutzung des mini-Modell ist deutlich günstiger, in der API sieht der Vergleich aktuell so aus:

Außerdem gibt OpenAI an, dass o1-mini deutlich schneller in der Anwendung ist und sich damit für Aufgaben, die hauptsächlich dieses logische Schritt-für-Schritt-Denken erfordern oft sogar besser eignet als o1-preview.

Der Vorteil, den o1-preview gegenüber dem kleineren Modell hat ist mehr eigentliches Wissen, von OpenAI als „broad world knowledge“ bezeichnet, das heißt im Klartext, wenn über die eigentlichen Kalkulationen hinaus Wissen über bestimmte Themen von Vorteil ist, kann o1-preview bessere Ergebnisse liefern. Aber auch hier werden wir in der Praxis vermutlich bald konkrete Unterschiede feststellen können.

Der Schritt von der Co-Intelligenz zu mehr Eigenständigkeit der KI

Die neuen Modelle von OpenAI unterscheiden sich grundlegend zu allem, was bisher auf dem Markt ist. Ethan Mollick, Professor an der Wharton Uni ist der Autor des Buchs “Co-Intelligence”, eines der aktuell meistgelesenen Bücher zum Thema Generative KI und Chatbots. In diesem Buch beschreibt er die KI als Mitarbeitenden, als Hilfe oder Assistenz.

Ethan hat bereits seit einem Monat Zugriff auf die neuen Modelle gehabt und seine Einschätzung dazu ist sehr beeindruckend: Er schreibt in einem Blog-Beitrag, dass die Zeit der Co-Intelligenz vorbei ist. Das O1-Modell macht in seinen Augen so viele Schritte, Überlegungen selbst und liefert so komplette Ergebnisse, dass man das Gefühl hat, die eigene, menschliche Rolle in dieser Beziehung ist nicht mehr entscheidend.

Natürlich muss man auch hier als Mensch auf Fehler der KI achten, die definitiv weiterhin passieren. Aber man ist nicht mehr so sehr involviert, durch die vielen Aufgaben, die man dem Gesprächspartner abnehmen muss.

Auch O1 und O1-mini sind nicht intelligent und haben kein Bewusstsein

Gleichzeitig sollten wir betonen: Man darf nicht dem Trugschluss verfallen, dass O1 intelligenter ist, oder ein Bewusstsein hat. Es ist ein vollständig anderes System, ja. Aber im Grunde sind es einfach mehr Schritte, komplexere Kalkulationen und eingebaute Reflektion über die ersten Schritte des Modells, die am Ende zu deutlich verbesserten Ergebnissen führen.

Und O1 ist nicht in allen Belangen besser als das vorangegangene GPT-4o-Modell. Es kann zum Beispiel nicht wirklich besser Texte schreiben, zusammenfassen oder ähnliches. Der entscheidende Unterschied wird nur bei entsprechend komplexen und mehrteiligen Aufgabenstellungen wirklich deutlich.

Wie anfangs angedeutet: Wir testen das neue Modell jetzt für euch wirklich im Detail und melden uns nächste Woche mit einem ausführlichen Bericht zu unseren eigenen Erfahrungen mit dem neuen Modell!