Egal ob es sich um Stereotypen, politische Meinungen oder allgemein kontroverse Themen handelt, viele größere Sprachmodelle verweigern für bestimmte Fragen eine klare Antwort oder passen sie zumindest so an, dass sie zwar diplomatisch ist, inhaltlich aber nicht wirklich zufriedenstellend.

Diese möglichen Einschränkungen sind aber nicht der einzige Grund, um ein eigenes Sprachmodell auf dem Computer zu installieren.

Gleichzeitig ermöglicht uns dieses Vorgehen nämlich maximale Privatsphäre und den Schutz unserer Daten, da alles komplett ohne Internetzugriff und das Senden unserer Eingaben an Server von irgendwelchen Unternehmen funktioniert.

In diesem Artikel zeigen wir, wie man eine künstliche Intelligenz ohne Einschränkungen oder Zensur ganz einfach lokal, ohne Internet als Chatbot auf dem eigenen Computer verwenden kann.

Das funktioniert dabei sowohl auf Windows, Mac als auch auf Linux und man hat die Wahl aus einer Unzahl von Top-KI-Modellen.

Und jetzt kommt das Beste: Für diese Methode braucht ihr keinerlei Kenntnisse über Kommandozeilenbefehle oder Code, es ist wirklich kinderleicht und es kostet euch keinen Cent.

So installierst Du deinen eigenen, lokalen KI-Chatbot

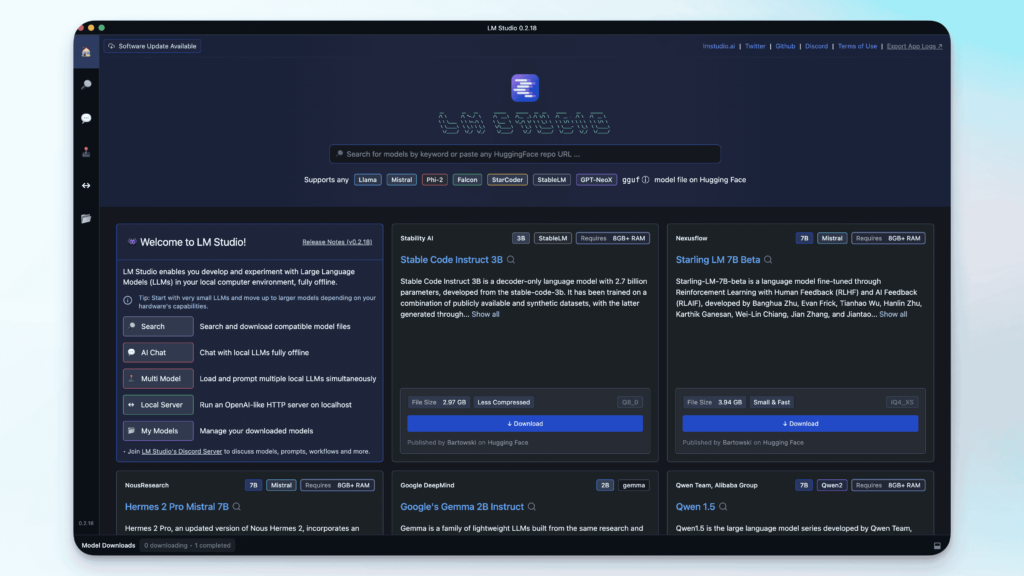

Der erste Schritt ist es, die Software LMStudio herunterzuladen. Du findest das Programm auf dieser Website und kannst je nach Betriebssystem die Version für Mac, Windows oder Linux auswählen.

Als nächstes müssen wir mindestens ein KI-Modell herunterladen, um es in LMStudio verwenden zu können. Dazu können wir entweder auf der Startseite des Programms oder in der Suche einen Begriff eingeben und dann die Ergebnisse nach dem von uns gewünschten Modell durchsuchen.

Es sind alle auf Huggingface verfügbaren Modelle gelistet, auf Huggingface selbst können wir auch immer mehr Informationen zu den Modellen bekommen oder uns auf die Suche machen, wenn wir noch gar nicht wissen, welches Modell wir eigentlich haben wollen.

Ein Beispiel für ein unzensiertes Modell wäre hier Dolphin 2.8, das auf Mixtral basiert.

Wenn man ein Modell aus der Liste auswählt, kann man zwischen verschiedenen Versionen wählen. Wichtig dabei: Die angegebene Größe des Modells, wir bei der Verwendung im RAM des Computers blockiert, also bei einer Modellgröße von ca. 8GB sollte man über zumindest 16GB RAM verfügen.

Nachdem ein Modell heruntergeladen wurde, können wir dieses im Chat-Bereich von LMStudio verwenden. Dazu wählen wir ganz oben im Dropdown das entsprechende Modell aus, um es zu laden. Dann wird der Arbeitsspeicher geblockt und wir können im Chat direkt loslegen.

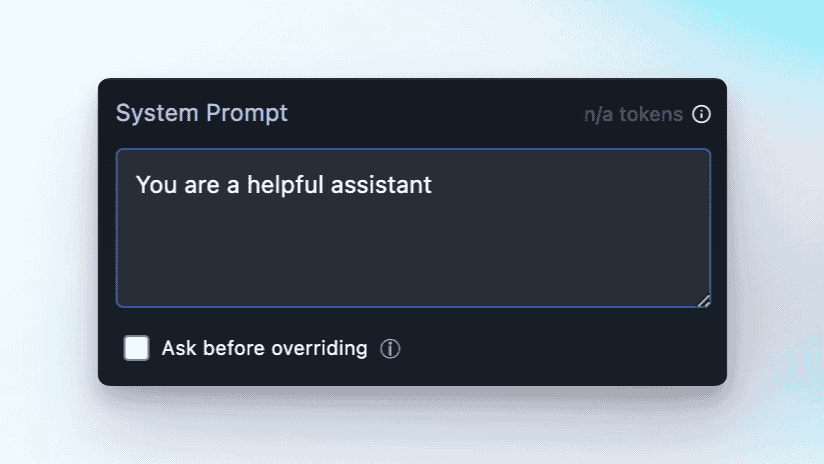

Als Systemprompt verwenden wir standardmäßig immer „You are a helpful assistant“ für allgemeine Anwendungen. Man kann hier aber natürlich auch spezifischer werden, wenn man eine bestimmte Anwendung im Kopf hat.

Ansonsten kann man direkt loslegen und im Feld bei User unten die Anfrage eingeben, mit der Enter-Taste abschicken und schon wird eine Antwort erzeugt. Das kann je nach Leistung des eigenen Computers etwas länger dauern, als man es von Online-Chatbots gewohnt ist, aber dafür bekommt man alle Vorteile der Offline Variante, die wir gleich noch auflisten.

Die Auswahl des richtigen KI-Modells

Man muss an dieser Stelle erwähnen, dass die Auswahl des Modells natürlich von der verwendeten Hardware und der gewünschten Verwendung beeinflusst wird. Wir haben in unserem Beispiel das kleine Dolphin-Modell gewählt, da es eben keine Zensur oder Einschränkungen hat und auf den meisten Computern ausführbar ist – ohne dass sie über eine Unmenge von Arbeitsspeicher verfügen müssen.

Wir finden in LMStudio auch wirklich richtig gute Modelle, zum Beispiel das erwähnte Command R Plus Modell von Cohere, das in der Chatbot Arena jetzt sogar eine Version von GPT-4 schlagen konnte.

Leider ist es schon ziemlich schwierig die großen Versionen davon zu testen, es wäre wirklich mal interessant zu sehen, wie gut ein lokaler Chatbot mit beispielsweise der 50GB Variante von Command R Plus sein kann, also wer von euch so viel Arbeitsspeicher hat, kann das ja gerne mal für uns alle ausprobieren.

Die Vor- und Nachteile lokaler Chatbots

Natürlich ist die Verwendung dieser Modelle in LMStudio eine super Alternative zu den üblichen webbasierten Chatbots wie ChatGPT oder auch Gemini. Trotzdem gibt es auch hier ein paar Einschränkungen, deshalb stellen wir einfach mal noch schnell die Vor- und Nachteile gegenüber.

✅ Vorteile

- Riesige Zahl von Open Source Modellen zur Auswahl

- Komplett kostenlos

- Offline-Nutzung

- Maximaler Datenschutz und Privatsphäre

- Unzensierte KI-Modelle verfügbar

❌ Nachteile

- Teilweise veraltete Trainingsdaten

- Große Modelle benötigen sehr viel Arbeitsspeicher und sind nicht immer eine Option

Wie unzensiert sind die KI Modelle wirklich?

Bei vielen gerade auch auf Huggingspace verfügbaren Modellen handelt es sich um existierende Open Source Modelle, wie Mixtral oder Llama, bei denen versucht wurde, jeglichen Bias oder Einschränkungen zu entfernen. Das sorgt in aller Regel auf jeden Fall dafür, dass weniger Anfragen komplett verweigert werden, oder nicht wirklich beantwortet. Gleichzeitig sind diese Einschränkungen nur ein Teil des Ganzen, denn genauso wichtig ist, mit welchen Daten die Modelle überhaupt trainiert wurden.

Auch bei der Auswahl dieser Daten kann schon darauf geachtet werden, dass gewisse Dinge oder Meinungen im Modell verankert werden, wenn es diese im Training eben oft “sieht”. Genauso können andere Informationen aus den Trainingsdaten komplett weggelassen werden und dann weiß das Modell darüber auch nicht Bescheid.

Ein eigenes Sprachmodell sozusagen komplett unzensiert zu trainieren ist aber eine Aufgabe, die nicht jede und jeder einfach mal so kurz machen kann. Neben den eigentlichen Daten braucht es eben auch das technische Knowhow und jede Menge sehr teure Rechenleistung. Die “ent-zensierten“ Modelle sind also aktuell eigentlich der einfachste Weg. Und die Lösung mit LMStudio macht das auch für alle von euch, die sich eben nicht so gut mit dem Terminal oder der Kommandozeile auskennen, relativ leicht möglich.

Ein Hinweis noch für Windows und Linux User. Um LMStudio auszuführen, muss eure CPU AVX2 unterstützen, das sollte aber bei allen relativ neuen Prozessoren kein Problem sein.